Visão geral de llama.cpp e LM Studio

Os modelos de linguagem percorreram um longo caminho desde o GPT-2, e os usuários agora podem implementar LLMs altamente sofisticados de forma rápida e fácil com aplicativos fáceis de usar, como o LM Studio. Juntamente com a AMD, ferramentas como essas tornam a IA acessível a todos, sem necessidade de codificação ou conhecimento técnico.

LM Studio é baseado no projeto llama.cpp; – que é uma estrutura muito popular para implantar modelos de linguagem de forma rápida e fácil. Não possui dependências e pode ser acelerado usando apenas a CPU, embora a aceleração por GPU esteja disponível. O LM Studio usa instruções AVX2 para acelerar LLMs modernos para CPUs baseadas em x86.

Comparações de desempenho: taxa de transferência e latência

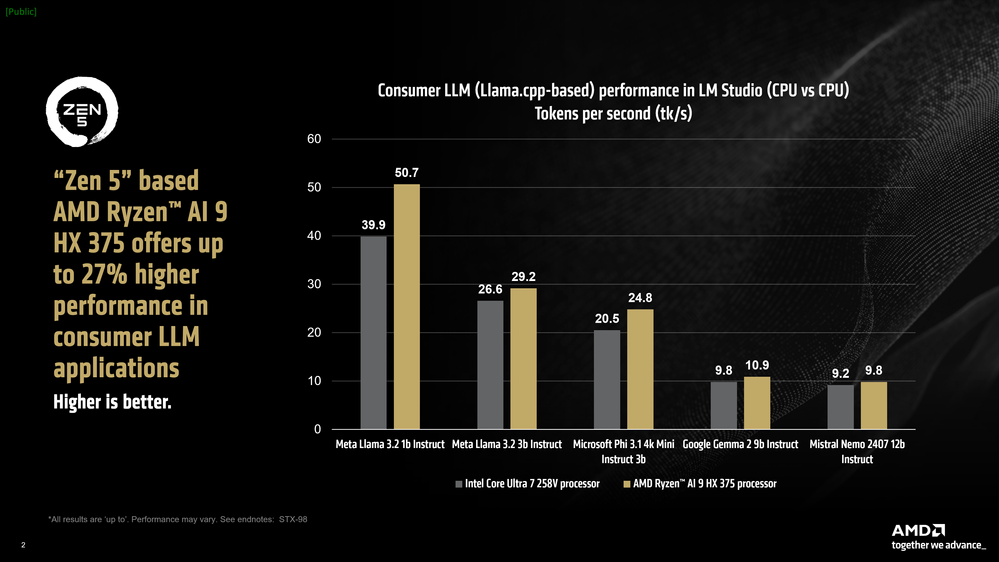

AMD Ryzen™ AI acelera essas cargas de trabalho de ponta e oferece desempenho líder em aplicativos baseados em llama.cpp, como LM Studio para laptops x861. É importante notar que os LLMs em geral são muito sensíveis à velocidade da memória. Em nossa comparação, o laptop Intel tem, na verdade, RAM mais rápida a 8.533 MT/s, enquanto o laptop AMD tem 7.500 MT/s de RAM.

Apesar disso, o processador AMD Ryzen™ AI 9 HX 375 tem desempenho até 27% mais rápido que a concorrência em termos de tokens por segundo. Para referência, tokens por segundo ou tk/s é a métrica que indica a rapidez com que um LLM pode produzir tokens (que é aproximadamente o número de palavras impressas na tela por segundo).

O processador AMD Ryzen™ AI 9 HX 375 pode atingir até 50,7 tokens por segundo no Meta Llama 3.2 1b Instruct (quantização de 4 bits).

Outra métrica para avaliar modelos de linguagem grandes é o “tempo até o primeiro token”, que mede a latência entre o momento em que você emite um prompt e o tempo que leva para o modelo começar a gerar tokens. Aqui vemos que nos modelos maiores, o processador Ryzen™ AI HX 375 baseado em AMD “Zen 5” é até 3,5 vezes mais rápido do que um processador concorrente comparável1.

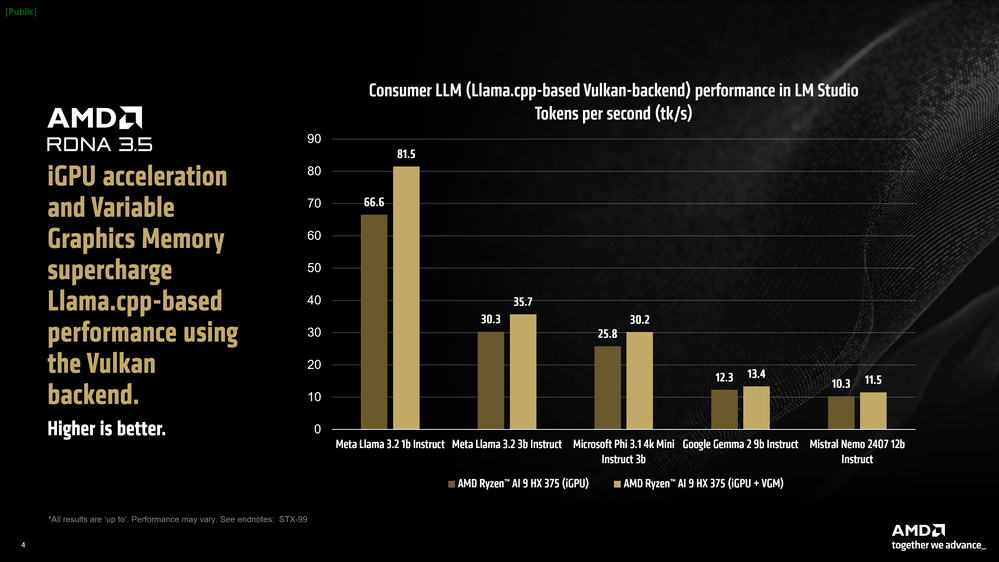

Usando memória gráfica variável (VGM) para acelerar o rendimento do modelo no Windows

Cada um dos três aceleradores encontrados em uma CPU AMD Ryzen™ AI tem sua própria especialização de carga de trabalho e cenários nos quais se destacam. Enquanto as NPUs baseadas na arquitetura AMD XDNA™ 2 fornecem incrível eficiência de energia para IA persistente ao executar cargas de trabalho Copilot+ e as CPUs fornecem ampla cobertura e compatibilidade para ferramentas e estruturas, é a iGPU que geralmente lida com tarefas de IA sob demanda.

O LM Studio possui uma porta llama.cpp que pode acelerar a estrutura usando a API Vulkan neutra em termos de fornecedor. A aceleração, neste caso, geralmente depende de uma combinação de recursos de hardware e otimizações de driver para a API Vulkan. A ativação do descarregamento de GPU no LM Studio resultou em um aumento médio de desempenho de 31% no Meta Llama 3.2 1b Instruct em comparação ao modo somente CPU. Modelos maiores, como o Mistral Nemo 2407 12b Instruct, que têm largura de banda restrita na fase de geração de token, tiveram um aumento médio de 5,1%.

Usando memória gráfica variável (VGM) para acelerar o rendimento do modelo no Windows

Cada um dos três aceleradores encontrados em uma CPU AMD Ryzen™ AI tem sua própria especialização de carga de trabalho e cenários nos quais se destacam. Enquanto as NPUs baseadas na arquitetura AMD XDNA™ 2 fornecem incrível eficiência de energia para IA persistente ao executar cargas de trabalho Copilot+ e as CPUs fornecem ampla cobertura e compatibilidade para ferramentas e estruturas, é a iGPU que geralmente lida com tarefas de IA sob demanda.

O LM Studio possui uma porta llama.cpp que pode acelerar a estrutura usando a API Vulkan neutra em termos de fornecedor. A aceleração, neste caso, geralmente depende de uma combinação de recursos de hardware e otimizações de driver para a API Vulkan. A ativação do descarregamento de GPU no LM Studio resultou em um aumento médio de desempenho de 31% no Meta Llama 3.2 1b Instruct em comparação ao modo somente CPU. Modelos maiores, como o Mistral Nemo 2407 12b Instruct, que têm largura de banda restrita na fase de geração de token, tiveram um aumento médio de 5,1%.

A AMD acredita no avanço da fronteira da inteligência artificial e em tornar a inteligência artificial acessível a todos. Isso não poderá acontecer se os últimos avanços em IA estiverem protegidos por uma barreira muito alta de habilidades técnicas ou de codificação, e é por isso que aplicativos como o LM Studio são tão importantes. Além de ser uma maneira rápida e fácil de implantar o LLM localmente, esses aplicativos permitem que os usuários experimentem modelos de ponta virtualmente assim que forem lançados (assumindo que o projeto llama.cpp suporte a arquitetura).

Os aceleradores de IA AMD Ryzen™ oferecem desempenho incrível, e a ativação de recursos como memória gráfica variável pode oferecer desempenho ainda melhor para casos de uso de IA. Tudo isso se combina para oferecer uma experiência de usuário incrível para modelos de linguagem em um laptop x86.

Você pode experimentar o LM Studio aqui.

Notas finais:

- Para esta comparação selecionamos os melhores laptops de 14 polegadas disponíveis no mercado norte-americano no momento da compra.

- STX-98: testes a partir de outubro de 2024 pela AMD. Desempenho médio de três execuções para o prompt de amostra “Explique o conceito de entropia em cinco linhas”. Todos os testes realizados no LM Studio 0.3.4. Modelos testados: Meta Llama 3.2 1b Instruct, Meta Llama 3.2 3b Instruct, Microsoft Phi 3.1 4k Mini Instruct, Google Gemma 2 9b Instruct, Mistral Nemo 2407 13b Instruct. (Todos os modelos são quantizados Q4 KM). Configuração específica da Intel: threads de CPU = 8. Configuração específica da AMD, threads = 12. (Llama.cpp recomenda definir threads iguais ao número de núcleos físicos.) Laptop HP OmniBook Ultra de 14 polegadas com AMD Ryzen AI 9 HX 375. 32 GB de RAM, 7500 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. ASUS Zenbook S14 UX5406SA 14 polegadas com Intel Core Ultra 7 258V. 32 GB de RAM, 8.533 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. O desempenho pode variar. STX-98.

- STX-99: testes a partir de outubro de 2024 pela AMD. Desempenho médio de três execuções para o prompt de amostra “Explique o conceito de entropia em cinco linhas”. Todos os testes realizados no LM Studio 0.3.4. Modelos testados: Meta Llama 3.2 1b Instruct, Meta Llama 3.2 3b Instruct, Microsoft Phi 3.1 4k Mini Instruct, Google Gemma 2 9b Instruct, Mistral Nemo 2407 13b Instruct. (Todos os modelos são quantizados Q4 KM). Threads de CPU = 12. (Llama.cpp recomenda definir threads iguais ao número de núcleos físicos.) Dreno de GPU = MAX. VGM definido para 16 GB durante execuções de VGM. Laptop HP OmniBook Ultra de 14 polegadas com AMD Ryzen AI 9 HX 375. 32 GB de RAM, 7500 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. O desempenho pode variar. STX-99.

- STX-100: testes a partir de outubro de 2024 pela AMD. Desempenho médio de três execuções para o exemplo de prompt: “Quanto tempo levaria para uma bola largada de uma altura de 10 metros atingir o solo?”, “Explique o conceito de entropia em cinco linhas”. Todos os testes foram realizados no LM Studio 0.3.4 para laptops AMD. Todos os testes foram realizados usando Intel AI Playground 1.21b para laptops Intel. Modelos testados: Mistral 7b Instruct v0.3 Q4 KM, Mistral 7b Instruct v0.3 sym_int4, Microsoft Phi 3.1 4k Mini Instruct Q4 KM, Microsoft Phi 3.1 4k Mini Instruct sym_int4. Configuração específica da AMD, threads = 12. (Llama.cpp recomenda definir threads iguais ao número de núcleos físicos.) Dreno de GPU = MAX. VGM definido para 16 GB durante execuções de VGM. Laptop HP OmniBook Ultra de 14 polegadas com AMD Ryzen AI 9 HX 375. 32 GB de RAM, 7500 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. ASUS Zenbook S14 UX5406SA 14 polegadas com Intel Core Ultra 7 258V. 32 GB de RAM, 8.533 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. O desempenho pode variar. STX-100.

- STX-101: testes a partir de outubro de 2024 pela AMD. Desempenho médio de três execuções para o prompt de exemplo: “Explique o conceito de entropia em cinco linhas”. Todos os testes foram realizados no LM Studio 0.3.4 para laptops AMD. Todos os testes foram realizados usando Intel AI Playground 1.21b para laptops Intel. Modelos testados: Mistral 7b Instruct v0.3 Q4 KM, Mistral 7b Instruct v0.3 sym_int4. Configuração específica da AMD, threads = 12. (Llama.cpp recomenda definir threads iguais ao número de núcleos físicos.) Dreno de GPU = MAX. VGM definido para 16 GB durante execuções de VGM. Laptop HP OmniBook Ultra de 14 polegadas com AMD Ryzen AI 9 HX 375. 32 GB de RAM, 7500 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. ASUS Zenbook S14 UX5406SA 14 polegadas com Intel Core Ultra 7 258V. 32 GB de RAM, 8.533 MT/s. VBS = ATIVO. Windows 11 Pro 24H2. O desempenho pode variar. STX-101.

- GD-220c: Ryzen™ AI é definido como a combinação de um mecanismo de IA dedicado, mecanismo gráfico AMD Radeon™ e núcleos de processador Ryzen que habilitam recursos de IA. A habilitação de OEM e ISV é necessária e alguns recursos de IA podem ainda não estar otimizados para processadores Ryzen AI. Ryzen AI é compatível com: (a) processadores AMD Ryzen série 7040 e 8040, excluindo os processadores Ryzen 5 7540U, Ryzen 5 8540U, Ryzen 3 744

FONTE